李开复:中国落后美国大模型差距缩小为 6 个月, 疯狂降价是双输

时间:24-05-24 来源:AI科技大本营

李开复:中国落后美国大模型差距缩小为 6 个月,

疯狂降价是双输

北京时间 5 月 21 日,仅仅时隔一周,李开复再度露面,带来了他的喜与忧。

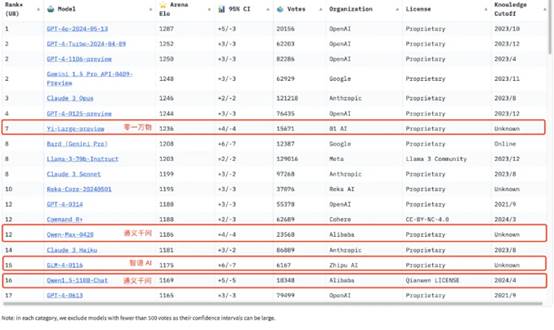

喜的一面在于,在 LMSYS 盲测竞技场最新排名中,零一万物的最新千亿参数模型 Yi-Large 总榜排名世界模型第 7,中国大模型中第一,已经超过 Llama-3-70B、Claude 3 Sonnet;其中文分榜更是与 GPT-4o 并列世界第一。除了零一万物的 Yi-Large 之外,通义千问、智谱 AI 的 GLM 亦在 TOP20 之列。

李开复表示中国大模型与美国大模型的差距,从一年多前落后 7-10 年的时间,已经缩小到 6 个月,差距实现了大幅降低。

而忧的一面则是,618 还未至,大模型已经进入了疯狂降价时。

前有字节跳动发布豆包大模型,让大模型价格进入“厘时代”,一元钱就能买到豆包主力模型的 125 万Tokens;紧接着阿里巴巴的通义千问官宣降价并立即生效,降价后,1 元最多=200 万 Tokens;更甚的是随之而来的百度官宣:文心大模型两大主力模型全面免费,立即生效。

面对着这股席卷而来的价格战之风,有人欢喜有人愁,这个问题的核心关键还是在于模型的商业化。贾扬清表示,“今天站在 AI 整个业界的角度,我想说,降价是个拍脑袋就可以做的简单策略,但是真正的 toB 商业成功更难。”而出门问问创始人李志飞也这样说道:“去年四月在经过无脑狂躁后,我就意识到 OpenAI 的两种商业模式(ToC 会员和 ToB API)在中国竞争环境下都是不可持续的。”

对此,李开复这样评价道:“国内常看到 ofo 式的疯狂降价、双输的打法。我觉得大模型公司不会这么不理智,因为技术还是最重要的,如果是技术不行,就纯粹靠贴钱赔钱的方式去做生意。我们(零一万物)绝对不会跟这样的一个定价来做对标,我们对自己的模型表现是非常自豪的……如果再问以后可能中国就是这么卷,大家宁可赔光通输也不让你赢,那么我们就走海外市场。”

01

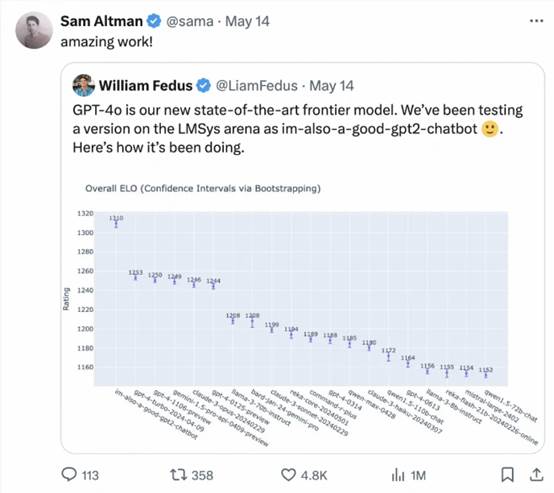

大模型竞技场,中国大模型崭露头角

前段时间,一款名为“gpt2-chatbot”的神秘模型突然现身大模型竞技场 LMSYS Chatbot Arena,排名直接超过了 GPT-4-Turbo、Gemini 1 .5 Pro、Claude 3 0pus、Llama-3-70b 等各家国际大厂的当家基座模型。正当 AI 圈里众说纷纭地猜测其究竟来自哪里、是否是 OpenAI 开发的 GPT-4.5 时,OpenAI 揭开了其神秘面纱,正是 GPT-4o 的测试版本,而 OpenAI CEO Sam Altman 也在 GPT-4o 发布后亲自转帖引用 LMSYS Arena 盲测擂台的测试结果。

LMSYS Org 是一个开放的研究组织,由加州大学伯克利分校、圣地亚哥分校和卡内基梅隆大学的学生与教师共同创立。其发布的 Chatbot Arena 以盲测的方式,由用户在模型匿名的前提下对模型效果进行打分,颇受业内认可,已经成为 OpenAI、Anthropic、Google、Meta 等国际大厂的大模型竞技场。

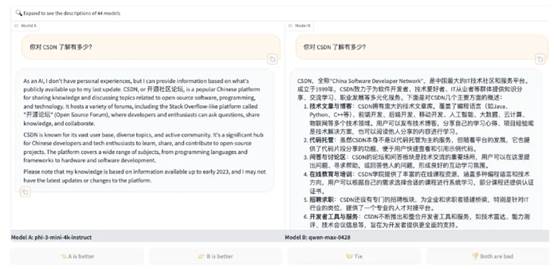

如下所示,在不知道具体使用哪个模型的前提下,先在聊天框里输入 Prompt,基于模型的回答质量满意度进行投票,投票后会显示出所用模型来。

在其最新榜单中,智谱 GLM4、阿里 Qwen Max 及 Qwen 1.5、零一万物 Yi-Large 及 Yi-34B-chat 都有参与盲测,在总榜之外,LMSYS 的语言类别上新增了英语、中文、法文三种语言评测,开始注重全球大模型的多样性。Yi-Large 的中文语言分榜上拔得头筹,与 OpenAI 官宣才一周的地表最强 GPT4o 并列第一,Qwen-Max 和 GLM-4 在中文榜上也都表现不凡。

颇值得开发者注意的是,在编程能力(Coding)排行榜上,Yi-Large 的 Elo 分数超过 Anthropic 当家旗舰模型 Claude 3 Opus,仅低于 GPT-4o,与 GPT-4-Turbo、GPT-4 并列第二。

对此,李开复表示,Yi-Large 是通用模型,并没有针对 Coding 的场景专门优化。在 CSDN 基于 Coding 的进一步询问中,零一万物技术联合创始人黄文灏补充道:“我们分析过用户需求,Coding 并不是大家非常广泛使用的场景,对于程序员而言,在实际场景中面对非常专业的 Coding 问题一般会用一些专门的 Coding 模型。我们也很惊奇 Yi-Large 在 Coding 上的评测表现非常好。当前,我们正在做一些 Coding 专项的优化,对于模型能力而言,编程是一个非常重要的场景,我们正在着手 Coding 专门模型的开发,在代码改写、长代码续写、代码补全等方面有着非常好的性能表现,之后我们会陆续将 Coding 专项模型开放出来。”

02

差距、降价、多模态……李开复直面若干问题

问:当前中美之间的差距是怎样的,该如何追赶?

李开复:我不是特别认为我们跟全球有差距,当然如果要在头部之间 PK 是有一定的差距,但是同时可能要考虑到人才、算力等的差异。Google 团队是 2000 人,OpenAI 是 1000 人,在我们这里把模型和 Infra 加起来也不到 100 人,而且我们用 GPU 算力做模型训练不到他们的 1/10,我们的模型尺寸也不到其 1/10。

如果只评估千亿模型,至少在 LMSYS 这个排行榜上是世界第一,这一点我们还是很自豪。在一年前我们落后 OpenAI 与 Google 开始做大模型研发的时间点有 7 到 10 年,现在我们跟他们差距在 6 个月左右,这个已经大幅降低。

这 6 个月是怎么来的?可以回到 LMSYS 6 个月以前的榜,或者今天比我们排名在前面的几家,几乎都是今年发出来的模型,去年的模型还在榜单上,我们已经打败了。

另一个角度来看,我们最新发布的模型在 5 月时可以打败去年 11 月之前的任何模型,所以我觉得也可以科学地推理出我们落后 6 个月。

6 个月的差别不是很大,这是一个不可思议的超级速度的赶追。

那么美国人才有没有独特的地方?肯定是有的,从我写的《AI·未来》这本书之后,我一直都坚持美国是做突破性科研,有着创造力特别强的一批科学家,在这方面全世界是没有对手的。但在同一本书里我也说了,中国人的聪明、勤奋、努力是不容忽视的,我们把这 7-10 年降低到只有 6 个月,就验证了做好一个模型绝对不只是看多能写论文,多能发明新事物,先做或后做,做得最好才是最强的,Google 搜索比雅虎晚做很多,但是完全无法比拟。所以我认为后发有后发的优势,但同时我们特别尊敬美国的创造性,有很多值得学习的地方。但是比执行力,比做出很好的体验,比产品,比商业模式,我觉得我们强于美国公司。

问:零一万物后续会推出更大参数的模型吗?现在一些企业开始做小模型,您认为现在卷参数还有意义吗?

李开复:我们的计划是从最小到最大的模型都希望能够做到中国最好,所以除了 6B、9B、34B,未来我们可能有更小的模型发布,它们都是同样尺寸达到业界最佳,不敢说第一,但是总体来说是第一梯队或者是 TOP1/2 这样的表现,而且在诸如代码、中文、英文等很多方面表现都非常好。

我们相信就像一周前我讲的 TC-PMF,永远是一个跷跷板,要平衡需要多强的技术,付不付得起技术所需要的成本。业界有各种不同的应用,从最简单的客服应用,到游戏,一直到非常难的推理策略、科学发现等难度,我相信大尺寸的 Scaling Law,最强大地往 AGI 走的模型,在最难的问题上,大家又愿意花钱的领域里,绝对是有落地场景,而且是最有可能达到 AGI。

同时我们也坦诚,有各种比较小的简单应用的机会。我们的打法是一个都不放过,在每一个潜在尺寸上发布我们能做到性能最高,而且推理成本最低,这个推理成本也会带来更好的定价给开发者使用。

问:零一万物的 GPU 可能是 Google、微软的 5%,算力对模型发展的限制是客观存在的。面对 OpenAI、Google 的能力、资源均靠前的情况,零一万物怎么应对?

李开复:这个更精确的应该从历史数据来看,看在过去的一两年他们提升了多少,我们提升了多少,我们是不是追得非常近了,这是一个客观事实。

我不认为他们的算力更大就表示我们绝对没有机会,当然他们的算力更大有巨大的优势,但是我觉得客观事实是我们能够把同样的一张 GPU 挤出更多的价值来,这是今天我们能够达到这些成果的一个重要理由。

另外是优化模型的性能表现,它不只是一个纯粹科技和算法的问题,其中还有数据的配比、怎么优化,同时优化训练和作用,还有我们的模型怎么加入多模态等等各种方面的技术,我们其实在这方面是不输于美国。

我们算力一直远远落后,一年前算力也是只有 Google、OpenAI 的 5%,现在还是,如果用 5%的算力能够把落后快速拉近,未来我们还是很期待有惊人的结果。

能不能达到第一,能不能超过,当然是一个艰难的任务,但我们是朝着这个目标在努力,今天的结果对比一周前,对比去年 11 月,对比我们成立的时候,都是一个不可思议的飞跃,所以看事情要看其是在上涨还是下跌,而非今天还是落后,以后就会落后。

问:现在国内打起了大模型价格战,在这个过程中零一万物和其他初创公司如何在竞争中跑赢大厂?

李开复:我们关注到了这个现象,我们的定价还是非常合理,而且也在花很大精力希望能够让它再降下来,我觉得一定程度上整个行业每年降低 10 倍推理成本是可以期待的,而且必然也应该发生的。今天可能处在一个比较低的点,但是我觉得如果说以后大约以一年降价 10 倍来看,这是一个好消息,因为今天的 API 模型调用还是一个非常低的比例,如果一年降低 10 倍,那众多的人都可以用上。

我们也认为今天可以看到的模型表现零一超过其他模型,也欢迎不认同的友商来 LMSYS 打擂台,证明我是错的。但是直到那一天发生,我们会继续说我们是最好的模型。

对要求、需求都最高的,需要最好模型的用户当然会使用我们。100 万个 token 花十几块还是花几块钱有很大差别吗?100 万的 token 对于很大、很难的应用,我们是必然之选。我们发布之后得到国内外非常高的评价,而且是可以横跨中国和外国的 API,都开放,我们有信心在全球范畴是一个表现很好、性价比也很合理的一个模型。

当然,国内常看到 ofo 式的疯狂降价,双输的打法。我觉得大模型公司不会这么不理智,因为技术还是最重要的,如果是技术不行,就纯粹靠贴钱赔钱去做生意,我们绝对不会跟这样的一个定价来做对标,我们对自己的模型表现是非常自豪的。

就像你如果有一台特斯拉,它不会因为别的品牌的车比它卖的很便宜,它就觉得它要降价,我们就是特斯拉,我们的价钱是合适值得的。

如果再问以后可能中国就是这么卷,大家宁可赔光通输也不让你赢,那我们就走海外市场。

问:GPT-4o 开始做原生多模态模型,统一文本、音频、图像、视频的输入输出的多模态大模型会是一个确定方向吗?可否透露一下零一万物在多模态的进展。

李开复:我们在去年一直都认可全模态模型,omni,也就是我们挑了同样的词已经在做这个工作,这个工作不是 OpenAI 出来再跟风能够跟得上的,我们有一定的积累,我们也相信全模态是正确方向。从我们的发布周期来说,在今年你们可以期待一个惊喜。

问:零一的 API 价格会不会下降?

李开复:现在没有调整的消息可以分享,我们收到的反馈还是非常正面的。我认为模型要看它的表现,可能有些领域,比如说一些很难收回钱的领域要看价格,反正有足够多的在选我们,我们刚上线,有这么多忠诚的爱好者加入了,我们先服务好他们,价钱再说。

到今天为止,我们刚宣布的性能肯定是国内性价比最高。大家可能有用千 token、百万 token,可以自己测算一下。

问:零一万物在产品化方面未来有没有一些规划?

李开复:有,上周发布的产品基本是我们的方向,一方面我们已经推出了一些非常成功的海外产品,已经在海外取得非常好的成功,今年预期会有大概 1 个亿的收入,而且不是烧钱模式烧出来的。

另外还有几个其他产品在国内外测试中,当然万知我们也会继续努力把它越做越好,尤其我们对 PPT 的功能得到非常正面的反馈,因为这是一个跟国内其他大模型很大的差异点,这个是我们面对消费者产品的分享。

在企业级方面也正在进行中,但现在初步用户在国外,国外用户的付费意愿或者付费金额比国内大很多,所以虽然我们也非常期望服务国内用户,但按照现在 ToB 卷的情况,几十万做 POC,几百万做一单,做一单赔一单的生意,我们早期在 AI 1.0 时代太多了,投入多了,我们坚决不做。

摘自-AI科技大本营

| 上一篇 | 下一篇 |

|---|---|

| 盘后飙升6%!英伟达宣布“1拆10”,Q1收入 猛... | 国家队下场收房,但这次救市 拉不动房价了 |